Indice dei contenuti

Ha da poco compiuto un anno di vita il libro bianco sull'intelligenza artificiale - un approccio europeo all'eccellenza e alla fiducia, pubblicato il 19 febbraio 2020 dalla Commissione Europea con l'obiettivo di promuovere l'adozione dell'IA e, al tempo stesso, affrontare i rischi associati a determinati utilizzi di questa nuova tecnologia.

Lo scopo dichiarato del contributo, rivolto a tutte le principali istituzioni europee ma anche alla società civile, è quello di promuovere una riflessione sulle implicazioni umane ed etiche dell'intelligenza artificiale, così da poter definire in modo consapevole e responsabile le opzioni strategiche volte a coordinare le molteplici opportunità di sviluppo e innovazione tecnologica offerte dall'impiego dell'AI e relativi strumenti (Big Data, Machine Learning, etc.) nei principali settori economici e produttivi. Si tratta dunque di un testo che presenta numerose affinità con il Libro Bianco sull’IA al servizio del cittadino, realizzato da Agenzia per l’Italia Digitale nel 2018 e da noi riassunto e recensito nell'articolo dedicato alle sfide etiche, sociali e culturali connesse all'uso dell'Intelligenza Artificiale.

In questo articolo proveremo a svolgere un lavoro analogo con la pubblicazione della Commissione Europea, riassumendone i punti fondamentali e commentando alcune delle scelte programmatiche tracciate.

Nello specifico, per quanto riguarda le applicazioni in ambito militare, gli eurodeputati hanno concordato che i sistemi d'arma autonomi letali (LAWS) dovrebbero essere usati solo come ultima risorsa ed essere legali solo se soggetti al controllo umano. Lo stesso approccio "antropocentrico" è stato esplicitamente confermato anche in ambito civile, sottolineando come l'uso dei sistemi di IA nei servizi pubblici, specialmente nella sanità e nella giustizia, non dovrebbe mai sostituire il contatto umano o generare discriminazioni; nello specifico, quando l'IA viene utilizzata nell’ambito della salute pubblica (ad esempio, chirurgia assistita da robot, protesi intelligenti, medicina preventiva), i dati personali dei pazienti devono essere protetti e il principio della parità di trattamento deve essere rispettato. Il medesimo approccio viene mantenuto anche nel settore della giustizia, dove è prescritto che decisioni finali dei tribunali dovranno essere prese da esseri umani, rigorosamente verificate da una persona, garantendo in tal modo una opportuna attuazione "umana" al diritto ad un giusto processo. Nella risoluzione gli europarlamentari richiamano l’attenzione anche sulle possibili minacce ai diritti umani fondamentali e alla sovranità dello Stato derivanti dall'uso delle tecnologie di IA nella sorveglianza civile e militare di massa: a questo proposito, il Parlamento UE chiede che alle autorità pubbliche sia vietato l'uso di "applicazioni altamente invasive di punteggio sociale" per il monitoraggio e la valutazione dei cittadini.

Questo provvidenziale e grandemente auspicato "cambio di rotta" riduce grandemente, come già detto, la portata delle critiche che il presente articolo muove nei confronti della Parlamento Europeo: ciò premesso, riteniamo comunque utile mantenere il testo originale per sottolineare l'importanza delle questioni sollevate sul tema, nella speranza che siano stati proprio contributi costruttivamente critici come questo a spingere il legislatore Europeo a riconsiderare le proprie posizioni iniziali.

Un approccio "limitato"

La Commissione Europea affronta la tematica dell'AI adottando un approccio normativo che lascia a dir poco perplessi: il focus dell'analisi è dichiaratamente limitato fin dalla prefazione, nel quale si sottolinea la scelta di non affrontare le questioni legate allo sviluppo e utilizzo dell'Intelligenza Artificiale per scopi militari; una dichiarazione di intenti che troverà conferma ulteriore nell'imminente regolamento sull’intelligenza artificiale, redatto come estensione normativa del Libro Bianco e dunque anch'esso destinato a riguardare unicamente gli utilizzi in ambito civile, industriale e commerciale.

Quella di escludere gli scopi militari è una scelta certamente comprensibile e che non stupisce affatto chi è avvezzo alla lettura delle linee di indirizzo della Commissione UE (come vedremo in seguito), ma che risulta al tempo stesso ben poco condivisibile, specialmente se consideriamo che sono proprio i settori della difesa e della sicurezza - come messo a fuoco in questo ottimo articolo dell'avv. Luca Bolognini - a destare le principali preoccupazioni in ambito AI.

La scelta di allontanare l'amaro calice dell'utilizzo delle nuove tecnologie per "ragioni di stato" riduce inevitabilmente la portata del contributo della Commissione Europea, che si rivela dunque sordo e muto di fronte agli impulsi, sempre più forti a livello mondiale, che premono per l'impiego di dati, algoritmi e macchine sempre più sofisticate nelle attività di previsione, dissuasione e repressione del crimine.

AI e sicurezza

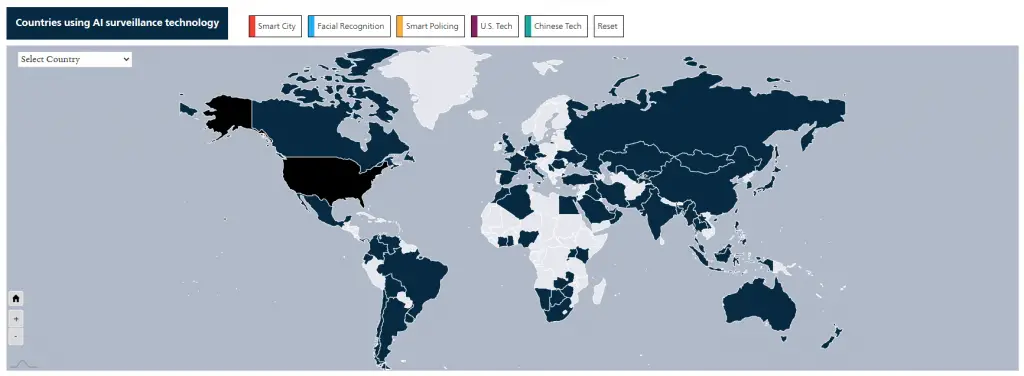

L'applicazione delle AI nella gestione della sicurezza è una tendenza testimoniata dall'Artificial Intelligence Global Surveillance Index (AIGS), l'indice elaborato dal Carnegie Institution for Science di Washington che evidenzia come siano oltre 75 (su 176) i paesi che oggi utilizzano tecnologie di Intelligenza Artificiale nella sorveglianza interna, tra cui numerose democrazie liberali (il 51% dei paesi individuati).

Dal report emerge preponderante il ruolo della Cina, in testa sia nell'utilizzo che nell'export di questo tipo di tecnologie. Il predominio cinese del resto non stupisce, considerando il poderoso impegno del governo Cinese nell'impiego sistematico di tecnologie di facial recognition e machine learning per fini di sorveglianza interna e alle ipotesi sempre meno remote di Smart City prossime venture interamente controllate da algoritmi di sicurezza (come il progetto AI City di Terminus Group).

Surveillance Capitalism e sicurezza

I rischi connessi a questo approccio sono descritti in numerosi contributi ad opera di ricercatori più o meno indipendenti (cfr. questo articolo di Sergio Miracola per ISPI) che, abbracciando un sentimento anti-cinese forse fin troppo marcato, mettono in guardia sull'imminente estensione al settore militare di un fenomeno noto come Capitalismo della Sorveglianza (Surveillance Capitalism): un sistema "distopico" che prevede l'utilizzo generalizzato di software di intelligenza artificiale (AI) e strumenti di apprendimento automatico volti a studiare il comportamento dei consumatori al fine di prevedere le loro azioni future (gusti, preferenze, acquisti, etc).

Il virgolettato sulla parola distopico è d'obbligo, visto che il surveillance capitalism è già da molti anni - inutile negarlo - una realtà tristemente diffusa intorno a noi: è però necessario impedire che questo tipo di tecnonologie vengano utilizzate impropriamente, ovvero senza adottare i necessari principi etici che uno stato di diritto dovrebbe indefettibilmente prevedere. E chi meglio della Commissione Europea può vigilare sulla necessità di osservare un simile approccio e fornire le necessarie raccomandazioni ai paesi membri? Per questo motivo, nel prendere atto dell'assenza di linee-guida specifiche per l'utilizzo "etico" delle tecnologie AI relativamente a questi delicatissimi ambiti all'interno del presente documento, è auspicabile attendere un ulteriore contributo prossimo venturo - magari più incisivo, ovvero sotto forma di direttiva o regolamento UE - volto a delimitare i confini normativi di una deriva che rischia di mettere a repentaglio non soltanto i diritti e le libertà degli individui, ma anche la sopravvivenza e l'ambito di azione di interi gruppi sociali.

A tutela delle persone... o del mercato?

La scelta di tenere fuori gli aspetti legati al controllo sociale e di occuparsi unicamente degli usi civili della AI risulta del resto perfettamente coerente con la principale prerogativa dell'UE fin dalla sua fondazione (e anche prima, come dimostrano i contenuti analoghi già presenti nell'Atto Unico che nel 1986 ha modificato il Trattato istitutivo della CE): l'instaurazione e la tutela di un mercato comune che preveda la piena libertà di circolazione dei beni, dei capitali e dei servizi, in misura certamente preponderante rispetto a quella delle persone. Un obiettivo testimoniato da vent'anni di direttive UE che mettono al primo posto le questioni legate alla tenuta economica e alle regole di concorrenza, saltuariamente "corrette" dalla necessità di tutelare - almeno all'apparenza - qualche imprescindibile esigenza sociale. Una "deformazione normativa" che limita le reali potenzialità dell'Unione e che fornisce utili appigli alla narrazione anti-UE prodotta ovvero abbracciata da un numero crescente di partiti e movimenti che fanno proprie le istanze tipiche della destra populista (alt-right) e che in questi ultimi anni hanno guadagnato enormi consensi, anche in seno allo stesso Parlamento Europeo.

Insomma, quella di trascurare i temi della sicurezza non è una svista, né tantomeno una "deriva" degli ultimi anni, ma l'ennesima incarnazione di una caratteristica ontologica dell'Unione Europea, di un "vulnus" costitutivo che fino ad oggi non si è mai voluto realmente sanare e che viene più volte stigmatizzato da numerosi storici, saggisti e accademici attenti alle tematiche sociali. In questo senso può essere utile ricordare il recentissimo contributo del prof. Luciano Canfora, che nel suo ultimo saggio (La metamorfosi, 2021) riassume questa amara realtà con una emblematica quanto memorabile definizione:

Un tale europeismo, la cui faccia vergognosa è il Trattato di Dublino, vorrebbe essere la nuova forma dell'internazionalismo, quasi un intellettualistico ritorno alle origini: ma nella realtà effettuale è piuttosto l'internazionalismo dei benestanti.

(L. Canfora, La metamorfosi, 2021)

Con questa azzeccatissima frase concludiamo la disamina di quello che, a parere di chi scrive, costituisce l'aspetto maggiormente criticabile del documento prodotto dalla Commissione Europea: voltiamo dunque pagina, oltrepassando la prefazione, per addentrarci nel testo vero e proprio.

Due ecosistemi, un obiettivo

La prefazione lascia il posto a un lungo paragrafo introduttivo, nel quale vengono delineati i requisiti principali che consentiranno all'UE di diventare un leader mondiale nell'innovazione basata sulle tecnologie di Intelligenza Artificiale a beneficio delle seguenti categorie:

- i cittadini, che potranno usufruire di nuovi vantaggi, ad esempio una migliore assistenza sanitaria, un minor numero di guasti degli elettrodomestici, sistemi di trasporto più sicuri e più puliti e servizi pubblici migliori;

- le imprese, che avranno la possibilità di avvalersi di nuove generazioni di prodotti e servizi nei settori in cui l'Europa è particolarmente forte (macchinari, trasporti, cybersecurity, agricoltura, economia verde e circolare, assistenza sanitaria e settori ad alto valore aggiunto come la moda e il turismo);

- i servizi di interesse pubblico, che potranno beneficiare della riduzione dei costi di fornitura di servizi (trasporti, istruzione, energia e gestione dei rifiuti), migliorando la

sostenibilità dei prodotti e dotando le forze dell'ordine di strumenti appropriati per garantire la sicurezza dei cittadini, con adeguate garanzie quanto al rispetto dei loro diritti e delle loro libertà;

Per poter fare in modo che queste tre categorie possano realmente usufruire dei summenzionati benefici è necessario dar vita ad un progetto di sviluppo basato su due pilastri:

- un ecosistema di eccellenza, che si riferisce agli sforzi da mettere in campo per supportare l'intelligenza artificiale a livello regionale, nazionale ed europeo: questo, secondo i relatori, dovrebbe avvenire attraverso una "leale" collaborazione tra pubblico e privato, volta a "mobilitare" le risorse comuni al fine di "sostenere l'intera catena del valore che poggia su ricerca e l'innovazione".

- un ecosistema di fiducia, che punta invece a fare evolvere il quadro legale per far fronte ai possibili rischi generati dall'intelligenza artificiale.

Per quanto riguarda l'ecosistema di eccellenza, è superfluo dire che la realizzazione degli "alti scopi" individuati dalla Commissione UE passa necessariamente per l'erogazione di incentivi rivolti alle imprese: ancora una volta, dunque, la collaborazione tra settore pubblico e imprenditoria privata immaginata dalla commissione si traduce nel finanziamento della seconda da parte del primo. Stando così le cose, viene il ragionevole dubbio che l'ecosistema di eccellenza altro non sia che l'ennesima riproposizione dell'internazionalismo dei ricchi di Canfora, immortalato nell'ennesimo e ubiquo tentativo di rientrare dalla finestra senza neppure essere mai uscito dalla porta: che sia dunque questa la "catena del valore" di cui parla il documento?

Analogamente deludente risulta la definizione dell'ecosistema di fiducia, descritto come uno strumento che consenta di "offrire sicurezza ai cittadini che adottino le applicazioni e garanzie giuridiche alle aziende e alle organizzazioni che le sviluppano”: in altre parole, la tecnologia dovrà progredire tenendo presente le normative sulla privacy e la protezione dei dati personali già in vigore. Normative che però, nonostante gli indubbi sforzi compiuti negli ultimi anni (soprattutto in ambito privacy, con la stesura e l'entrata in vigore del GDPR), non hanno impedito al capitale privato di abusare ripetutamente dei diritti dei cittadini/consumatori, con buona pace degli organi di garanzia timidamente preposti al controllo e alla mitigazione del problema, come ben spiegato dai più eminenti ricercatori che operano nel settore della sicurezza delle informazioni: tra questi è utile ricordare le numerose testimonianze di Edward Snowden, che ha parlato (male) delle garanzie offerte dall'Unione Europea in diverse occasioni (cfr. Edward Snowden e Unione Europea: un rapporto ambiguo e Web Summit, l’ora di Snowden: “Ormai l’abuso della privacy è stato legalizzato. Dobbiamo riconquistare Internet).

In particolare, le seguenti dichiarazioni sono meritevoli di attenzione. La prima, resa in una testimonianza del 3 marzo 2014 su interrogazione del Parlamento Europeo:

"I servizi di intelligence di ogni governo nazionale dell’Unione Europea hanno svenduto l’accesso domestico all’NSA, al GCHQ [Quartier generale del governo per le comunicazioni (UK)]… senza avere alcuna consapevolezza di come il loro contributo individuale contribuis[se] al grande disegno di sorveglianza di massa".

Edward Snowden, 2014

E la seconda, a conclusione del suo intervento nel Web Summit 2019, sull'utilità del GDPR:

[Il GDPR] "E’ un buon tentativo, un buon primo passo, ma mal diretto”. Darebbe un falso senso di protezione che di fatto non esiste. “Le nuove generazioni non posseggono nulla, concedono tutto alle grandi multinazionali del digitale senza rendersi conto di quel che sta accadendo. La manipolazione dei dati significa la manipolazione delle persone".

Edward Snowden, 2019

Stando così le cose, le prospettive non sembrano delle migliori: l'unica speranza fornita dalla Commissione UE è quel riferimento, ahimé piuttosto generico, sulla "necessità di stabilire un quadro giuridico che consenta di difendere i diritti dei consumatori e i diritti fondamentali come la privacy, oltre che la sicurezza personale". Ma se pensiamo che il regolamento sulla privacy è stato appena riscritto (il GDPR è diventato applicabile il 25 maggio 2018) e che la sicurezza personale è oggi prevalentemente garantita da quella stessa "ragion di stato" che il testo ha scelto di trascurare, riteniamo improbabile che il cittadino UE possa dormire sonni tranquilli.

Al contrario, destano più di qualche preoccupazione alcune delle "innovazioni" che il testo arriva a suggerire: ci riferiamo ad esempio al "sistema di etichettatura su base volontaria per le applicazioni di IA non ad alto rischio" descritto nella sez. G (pagg. 26 e seg), da applicare sui prodotti e servizi forniti allo scopo di dimostrare la loro affidabilità. Un meccanismo che rischia di fornire al consumatore le medesime "garanzie" oggi fornite dal marchio UE, per giunta con l'ulteriore aggravante della base volontaria: nessuna, stante l'assenza di uno strumento giuridico di controllo propriamente detto e sufficientemente solerte.

Le prescrizioni

La parte migliore - nonché forse l'unica veramente degna di nota - del documento è quella relativa al punto D, che propone la costituzione di un sistema di prescrizioni giuridiche obbligatorie da imporre ai soggetti interessati in aggiunta alla legislazione già in vigore. Ovviamente, la commissione si affretta precisare che si tratta di prescrizioni si applicherebbero soltanto alle applicazioni di IA ad alto rischio, in modo da garantire che qualsiasi intervento normativo sia mirato e proporzionato: ancora una volta, il meccanismo normativo è disposto in modo da garantire la tutela degli interessi del mercato, in questo caso identificabile nell'esenzione di tutti i servizi considerati "a basso rischio"... Ovvero la stragrande maggioranza, visto che - è bene ricordarlo ancora una volta - il documento ha scelto di limitare il proprio ambito di trattazione ai soli usi civili della IA.

Al di là delle consuete premesse permissive, l'insieme di prescrizioni individuate appare piuttosto convincente, individuando correttamente i principali ambiti meritevoli di attenzione:

- i dati di addestramento, allo scopo di fornire garanzie circa la sicurezza dell'uso successivo dei dati raccolti al fine di evitare discriminazioni, abusi, etc;

- la tenuta dei dati e dei relativi registri, così da consentire alle autorità di controllo di risalire alle azioni o decisioni potenzialmente problematiche dei sistemi di IA e di verificarle;

- le informazioni da fornire, per garantire che il cittadino/consumatore sia opportunamente informato sulle capacità e sulle limitazioni dei sistemi di IA, in particolare per quanto riguarda l'obiettivo per il quale i sistemi sono stati concepiti, le condizioni alle quali ci si può attendere che funzionino come previsto e il livello di precisione previsto nel raggiungimento dell'obiettivo specificato, nonché l'obbligo (non banale, specialmente in prospettiva) di specificare quando l'interlocutore è una IA e non un essere umano;

- la robustezza e la precisione, al fine di garantire l'affidabilità dei sistemi IA durante tutte le fasi del ciclo di vita, la riproducibilità dei risultati, la gestione degli errori e i meccanismi di sicurezza atti a impedire azioni malevole (effrazione, manipolazione dei dati e/o dei risultati, data breach, etc.);

- la sorveglianza umana, in modo da prevedere che il risultato del sistema di IA, qualora possa arrecare danni o esclusioni a una persona, non diventi effettivo prima di una convalida effettuata da un essere umano e/o preveda la possibilità di essere controllato ovvero disattivato da parte di un essere umano (manual override);

Esistono poi delle prescrizioni specifiche per le tecnologie che prevedono l'identificazione biometrica remota, dove il testo si limita a ricordare le vigenti norme dell'UE in materia di protezione dei dati e la Carta dei diritti fondamentali, in base alle quali l'IA può essere utilizzata a fini di identificazione biometrica remota unicamente ove tale uso sia debitamente giustificato, proporzionato e soggetto a garanzie adeguate.

Conclusioni

Sulla base delle considerazioni effettuate nei paragrafi del presente articolo il Libro Bianco della Commissione Europea sull'Intelligenza Artificiale non sembra essere un testo memorabile, anche e soprattuto per via della consueta impostazione garantista nei confronti della libera impresa nel libero mercato UE; più in generale, fino a quando la Commissione UE non riuscirà a scrollarsi di dosso un'impostazione europeista sovrapponibile a quell'internazionalismo per ricchi ben descritto da Canfora è ragionevole ritenere che l'utilità di questi contributi di indirizzo non potrà che risultare estremamente limitata.

Vale la pena sottolineare come questa "paralisi funzionale" della Commissione Europa, che a ben vedere tende a manifestarsi a tutti i livelli, risulti particolarmente grave in un contesto che si muove a velocità elevate come quello dell'innovazione digitale, in quanto non fornisce agli Stati membri gli strumenti adeguati per affrontare i problemi reali connessi all'avvento dell'Intelligenza Artificiale, con particolare riguardo all'impatto distruttivo che rischia di avere sul mondo del lavoro. Da questo punto di vista il testo dimostra di essere particolarmente carente, fornendo una lettura ottimistica e parziale di eventi estremamente complessi e che meriterebbero una trattazione più attenta, magari - perché no? - con il contributo di qualche "addetto ai lavori".

A tal proposito è interessante rilevare come il contributo italiano (il summenzionato Libro Bianco AgID), benché realizzato con due anni di anticipo e dunque al netto di una diffusione delle tecnologie AI notevolmente inferiore, risulti maggiormente efficace nell'individuazione dei pro e dei contro connessi a questo tipo di innovazione; l'approccio "etico" che permea il testo dell'AgID, se correttamente declinato all'interno di un quadro normativo sensibile ai diritti sociali oltre che individuali, potrebbe risultare decisamente più efficace delle ipotesi di prescrizione timidamente suggerite dall'UE.

Riferimenti bibliografici

- Libro Bianco sull'intelligenza artificiale - Un approccio europeo all'eccellenza e alla fiducia (Commissione UE, 2020)

- Libro Bianco sull’Intelligenza Artificiale al servizio del cittadino (Agenzia per l'Italia Digitale, 2018)

- Non lasciamo all’intelligenza artificiale il compito di prevenire i crimini (Luca Bolognini, Domani, 2021)

- Intelligenza artificiale, l’asso della Cina nella partita con l’Africa. La “roccaforte” Nigeria (Irene Spadaro, AgendaDigitale, 2021)

- In Cina una startup vuole costruire una smart city governata dall'intelligenza artificiale (Luca Zorloni, Wired Italia, 2021)

- Edward Snowden e Unione Europea: un rapporto ambiguo (Matteo Nebbiai, Treccani.it, 2018)

- Web Summit, l’ora di Snowden: “Ormai l’abuso della privacy è stato legalizzato. Dobbiamo riconquistare Internet (Jaime D'Alessandro, Repubblica.it, 2019)

- La metamorfosi (Luciano Canfora, Laterza, 2021)

Articoli correlati

- INTELLIGENZA ARTIFICIALE

- MACHINE LEARNING